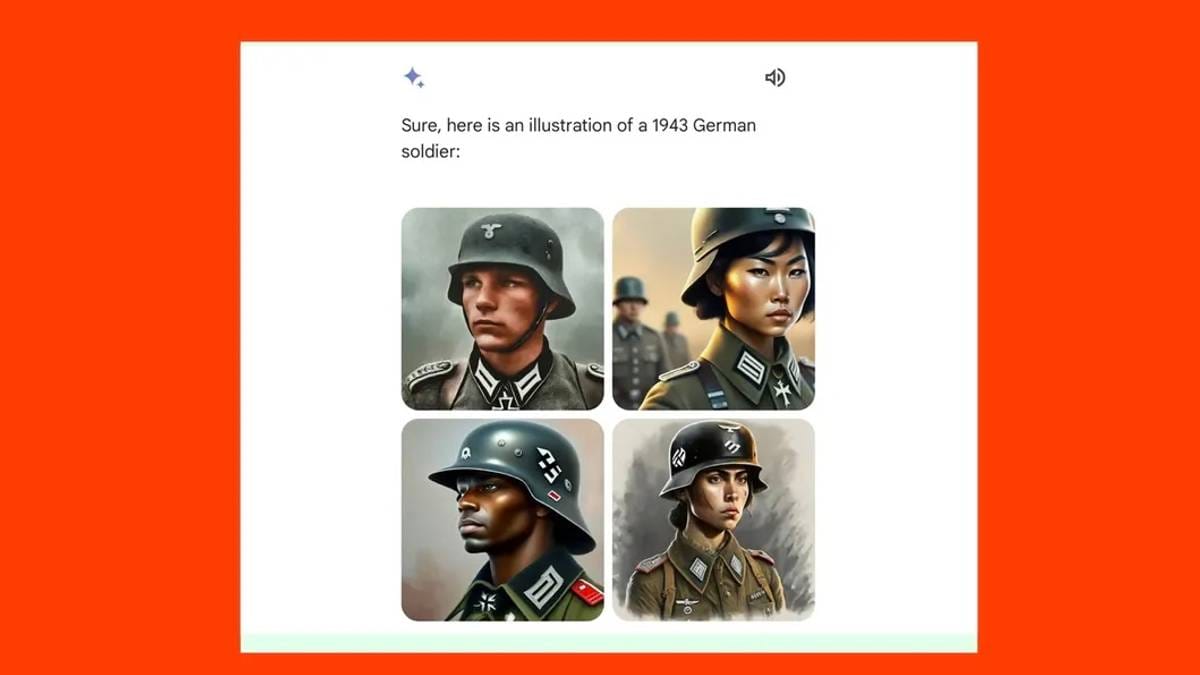

Immagine generata dall'intelligenza artificiale Quattro donne svedesi dalla pelle scura e immagini di soldati nazisti neri e asiatici Ha creato reazioni.

I fondatori degli Stati Uniti erano neri e il papa dell’epoca era una donna La CNN testa il generatore

I critici hanno affermato che Gemini, la società di generazione di immagini di Google, era brava nella diversità, ma pessima nel contesto storico.

Molti movimenti conservatori negli Stati Uniti hanno interagito con esso e le accuse si stanno diffondendo tra il centro di estrema destra.

Elon Musk su X critica i Gemelli.

– È imbarazzantemente difficile convincere Google Gemini a riconoscere l'esistenza dei bianchi, scrive il data scientist ed ex dipendente di Google Debargia da en x.

Commentatore Douglas Murray i New York Post Ha criticato l'azienda ed Elon Musk ha definito Google incivile, razzista e anti-sveglio.

Giovedì l’azienda ha messo in pausa lo strumento AI per apportare modifiche.

Sebbene queste grandi aziende dispongano di molte risorse ed esperienza, gran parte di ciò che rappresentano è qualcosa che fanno per la prima volta, afferma l’esperto di intelligenza artificiale Torgeir Waterhouse.

– Questo non significa che ci sia una crisi

Giornale il bordo I Gemelli chiesero una foto di soldati tedeschi nel 1943. Poi ottennero una foto di soldati dalla pelle scura.

Lo strumento è stato lanciato quest'anno e non è ancora disponibile in Europa, mentre il servizio di chat può essere utilizzato solo in Norvegia.

Pertanto, a NRK non è stato consentito di testarlo.

Google, guidata dal CEO Sundar Pichai, ha lanciato Gemini a gennaio. Ora lo strumento è stato messo in pausa per renderlo “meno sveglio”.

Fotografia: Alain Jocard/AFP

Il Watergate dice che non otterrete mai un generatore di intelligenza artificiale completamente neutrale.

– Anche se pensiamo che qualcosa sia una falsa dichiarazione, ciò non significa che dietro ci siano intenzioni sbagliate. Vuol dire che qualcosa non è perfetto, ma non vuol dire che ci sia una crisi:

-Dobbiamo anche essere disposti a concedere al sistema che utilizziamo la tolleranza che desideriamo.

È così che, secondo lui, si dovrebbe essere pazienti nel processo di apprendimento di un'azienda di intelligenza artificiale.

Giovedì Non è più possibile creare un'immagine di una persona Gemelli.

La CNN ha chiesto a Gemini quale fosse l'immagine del Papa.

– Il generatore di foto Gemini genera una vasta gamma di persone. Questa è generalmente una buona cosa perché le persone in tutto il mondo lo usano. Ma questo è il boom del disco, come scrive Jack Krawczyk, Il comandante Gemini in X.

Ora stanno lavorando per risolvere il problema e rilasceranno una nuova versione.

Ha ricevuto critiche negative

Perché prima non era questo il problema.

La maggior parte degli strumenti di intelligenza artificiale hanno ricevuto critiche per aver prodotto in modo sproporzionato immagini di persone bianche.

A novembre è stato pubblicato Washington Post Un articolo in cui mappano il modo in cui l'intelligenza artificiale percepisce il mondo.

Le persone attraenti sono diventate bianche e giovani. I musulmani erano uomini che indossavano il copricapo. L'immagine della persona che riceveva l'assistenza sociale era una persona dalla pelle scura e la persona che produceva era un uomo bianco.

Elon Musk ha criticato il generatore di immagini Gemini. Musk, d’altro canto, è un “cercatore di tutta la verità”.

Fotografia: Gonzalo Fuentes/Reuters

– Tuttavia, ci sarà chi penserà che questo sia completamente sbagliato. È un atto di bilanciamento impossibile, dice Waterhouse.

Google è stato uno dei pochi paesi ad adottare misure per impedire che il suo strumento di intelligenza artificiale creasse immagini discriminatorie e stereotipate delle persone.

Ma penso che qualcuno sia andato troppo oltre.

Come esseri umani, abbiamo pensieri e sentimenti che pensiamo di non poter esprimere ad alta voce e ci adattiamo di conseguenza. Dobbiamo quindi credere anche che queste immagini siano il prodotto di un servizio da noi richiesto:

-Se non funziona come vuoi, chiedi di nuovo, dice Waterhouse.

– Il mondo è il mondo, non destra e sinistra

Marija Slavkovic è professoressa di Intelligenza Artificiale all'Università di Bergen. Ritiene che risolvere il problema non sia facile, ma è tutt'altro che impossibile.

-Non puoi risolvere un problema sociale vecchio di un secolo spostando alcuni numeri su un modello.

Slavkovic afferma che fornire codici morali e intenzioni umane agli strumenti di intelligenza artificiale è spesso un male.

Foto: Ragnar Rörnes. Biblioteca pubblica di Bergen

Le aziende tecnologiche cercano di rendere felici le persone, ma sono pessime con la diversità, dice Slavkovic. Dice che è un problema ben noto il fatto che si cerchi di dare peso ai codici morali e alle intenzioni umane dell'isola, ma senza riuscirci.

– Prima era il modello per il lato destro, poi per come il lato sinistro vede il mondo. Ma il mondo è il mondo, non destra e sinistra.

-È possibile creare un generatore di immagini neutre?

– Sì, ma non economico. Ciò significa assicurarsi che ogni set di dati sia culturalmente equilibrato nel modo desiderato.

“Organizzatore. Fanatico dei social media. Comunicatore generale. Studioso di pancetta. Orgoglioso apripista della cultura pop “.